SEO的系统化策略

来源:中国网络传播网 作者:佚名

【抓取与收录】

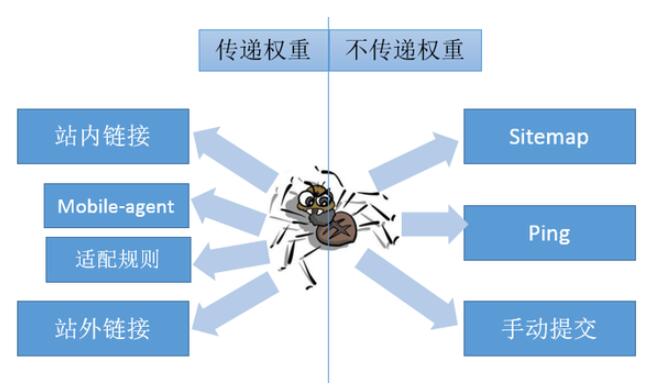

搜索结果页是站点之间竞争用户的战场,要想在竞争中获胜,首先你得站到战场上去。根据之前说到的搜索引擎的原理,我们知道,要在搜索结果页中出现,首先生产的页面要被搜索引擎的蜘蛛抓取。蜘蛛发现网页,正常情况下是通过站内的链接,和站外的链接,按照广度优先的原则,提取页面中导出的

URL。一般来说,站长还可以通过提交

Sitemap,

Ping通知蜘蛛,手动提交等方式,帮助蜘蛛发现有效的

URL。

前面说到,通过链接抓取网页,按照广度优先的原则。一般的小站,搜索引擎从起点页抓取三四层的深度也就不错了,一般这个起点页都是网站首页。所以

SEO要将网站整体设计成扁平的结构,有些时候需要为蜘蛛搭一些梯子,帮助它在较短路径上接触到更多的

URL。举个例子,

一般情况下,一个页面内导出链接不能过多,超过某个值蜘蛛就不抓了。之前的经验是

100,但是这个数值还是跟网站和具体页面有关。在网站层级和单页导出链接总量两个约束条件下,还有一点文章可做,那就是时间。单个页面导出链接最多是

100,如果我每天换掉其中的

50个呢

? 一个最简单的实现方式是借助于缓存机制,固定的取

50个,另外再在全集中随机取

50个,这

50个设置缓存时间

1天,

1天后失效,再随机取

50个,这样可以最大化导出链接的时效性,就像广告的分时段轮播一样。这里的数字可以根据实效进行调整。站内如此,对于批量交换的外链,也可以按照类似的方式实现。

一般情况下,一个页面内导出链接不能过多,超过某个值蜘蛛就不抓了。之前的经验是

100,但是这个数值还是跟网站和具体页面有关。在网站层级和单页导出链接总量两个约束条件下,还有一点文章可做,那就是时间。单个页面导出链接最多是

100,如果我每天换掉其中的

50个呢

? 一个最简单的实现方式是借助于缓存机制,固定的取

50个,另外再在全集中随机取

50个,这

50个设置缓存时间

1天,

1天后失效,再随机取

50个,这样可以最大化导出链接的时效性,就像广告的分时段轮播一样。这里的数字可以根据实效进行调整。站内如此,对于批量交换的外链,也可以按照类似的方式实现。

对于移动页面,有两种主要的机制通知到蜘蛛

PC页与移动页的对应关系,一是在

PC页头部加上

mobile-agent的

meta属性,二是在站长工具提交

PC/移动页对应关系的正则

(也可以提交全量的

URL地址对

)。

抓取这个环节至关重要,站长平台的抓取频次,和通过

accesslog分析得到的抓取明细,都需要时刻监控。小站的

log文件,市面上有些一些日志分析工具,自己写也

OK。对于大站的

log,很多都存储于

hadoop这样的分布式存储上,一般需要定制程序去分析处理。为了即时分析处理,快速反馈,可能需要接入流式计算框架

(kafka+storm)。

对于蜘蛛抓取行为数据的使用,可以用来评估蜘蛛对于站内页面价值的评定,可以用来反馈辅助抓取所做的一些优化的效果,可以预估新生成页面被搜索引擎接受的程度,等等。没有使用价值的数据是没用的,数据跟具体的应用场景结合起来,才能体现其价值。

对于抓取的页面,蜘蛛建立倒排索引后,会进行价值判定,按照价值高低,存储在分级索引库中。高级别的索引库才会参与最终的搜索排序。

一般

SEO开始学的时候,都会接触到

site语法,基本上所有常见的搜索引擎也都支持

site语法去查询域名或者目录级的收录量查询。在

site查询语句的后面加上一个词,可以查询得到该域名与这个词相关的页面。比较有价值的是,

site语法查出来的结果,按照网页的价值倒序排列。这个特征便使得依据相关性内链,提升第二页

/第三页落地页的排名成为可能。

【排名与流量】

对于有搜索量的词,获得好的排名,几乎确定了能获得流量。这里说几乎,因为还有一个点展比

(点击量除以曝光量

)的概念。按照谷歌的规律,

PC搜索结果中,前四位获得点击的几率是

42%,

12%,

9%,

6%。

先说排名。说到搜索排序,有很多场景下可以用到,比如在搜索结果页中的推广链接区域有个排序;在淘宝里面搜索,商品返回的结果列表有个默认的排序;

App Store中搜索也会按照一定的规则返回结果列表;同样的,在广告投放中候选广告创意去竞争一个展示机会时也有一个排序。这些排序与自然搜索的排序有一个共同点,即为了用户体验,将最好的,最符合用户需求的排在前面,从而提升用户体验。

影响自然搜索排序的因子应该很多,众所周知的,如网站自身的权威性与价值,网页的导入链接权重,网页结构

/速度,网页内容的原创性,以及最重要的,用户搜索词的出现频次,页面

Title与

H标签中出现搜索词的频次,等等。这是事前的因素。

有一点特别要提及的,搜索引擎为了构建良好的搜索竞争生态,对新站有个补偿机制。这也是实际有效的排序因子。

还有一点事后的因素,获得排名,用户点击,之后是否还点击了别的搜索结果。如果你的页面排在某个词的搜索结果第一位,搜索用户点击了你以后,还总会点击第二位的结果,那显然第二位的结果更符合用户需求,排序如何变化可想而知。这点可以从百度公开的专利中找到依据,点击器也是利用这个原理来实现的。

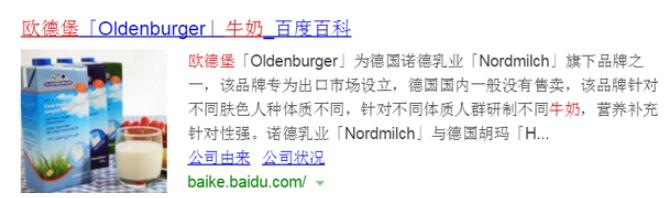

获得排名的搜索结果,展现给用户的信息包括,页面

Title,

Description或者页面内提取的信息摘要,缩略图,首页的子链接。后面两者可能有,也可能没有。还有一个相对次要的因素,搜索结果的域名

/链接摘要。如何在获得曝光的情况下,吸引用户点击

? 除了让自己的排名尽量靠前外,可以做的事情还包括,优化

Title/Description的文案,在页面主体区域提供合适尺寸的图片增加被作为缩略图的几率等。搜索结果条目示例如下

:

百度自己的产品虽然有被提权的嫌疑,但是从

SEO的角度看,仍然有很多值得学习的地方。对于一些如果不确定,可以研究百度自己的产品,看具体的实现方式。

经过了关键词,内容,页面,抓取,索引

/收录,排名,流量,这个漫长的链条,我们再回头来看封面上的漏斗模型,可以从中反思,我们的短板在哪里,机会又在哪里。如果将这些数据汇集在一起,随时利用这个数据链去监控网站的

SEO状况,利用数据对一些优化操作进行效果监控,甚至通过定义一些自动化的策略,使得系统自己可以实施一些优化操作,并利用数据反馈,再调整,再优化,实现智能优化,真正发挥数据的威力。

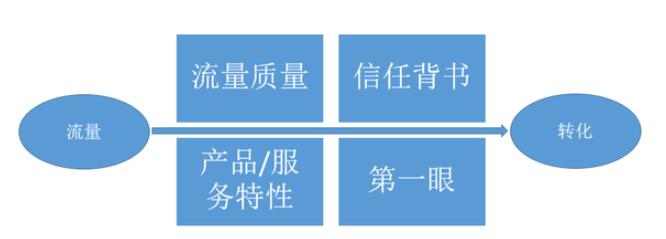

【流量到转化】

SEO流量获取的问题解决以后,就要考虑怎么去承接这些流量了。与广告类似,流量的目的一般是两个,品牌曝光,直接效果。品牌曝光一般难于做效果监控,所以本篇主要聊直接效果。

实际上,承接的效果如何,对于获取流量的能力又有很大的影响。外部来说,内容不满足搜索用户的需求,跳出率高,搜索引擎里面的排名会掉。内部来说,老板看的是最终目标,曝光量大,转化多,成单多,可以让老板更重视

SEO,给更多资源,有了资源,就可以更好的做

SEO,从而形成一个良性循环。

以直接效果为目标的流量,转化可能受到四个因素的影响,

1.流量的质量,或者说流量背后的用户跟自身需要服务的用户的重叠程度,把不相干的流量引来,可能是做无用功,用术语说,就是要做到精准营销;

2.用户触达站点时对于有几分信任,有信任作为背书,往往转化也会高些,比如知名品牌的官网往往转化会高,搜索一般的商品品牌/店铺名的流量,本身对目标有认知,转化也会高一些;

3.自身提供的产品或者服务本身的特性,有些情况下用户决策很快,比如单价较低的,标准化的东西的购买,这种比较容易形成转化;

4.给用户第一眼看到的内容,就电商这个行业来说,页面上展现相关的促销信息,或者提供给用户更多的选择机会,则会有更高的概率转化,比如列表页优于单页。

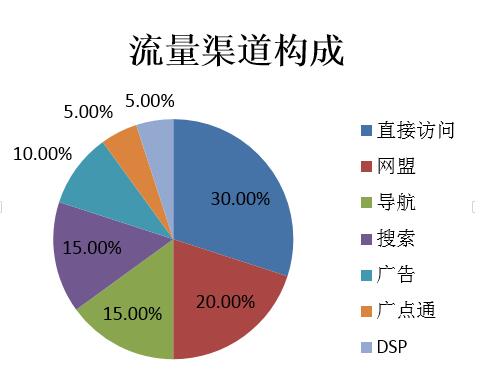

不同的行业

/不同的承载方式

(网站

/APP/微信

/淘宝店

/自媒体等

),有不同的流量获取渠道和方式,不同渠道的流量占比也会各有不同。比如京东的网站,应该包括但不限于如下一些渠道,直接访问,搜索引擎

(PPC/品专

/SEO),导航站,返利站,导购站,输入法弹框,网盟

(自有

/第三方

),广告,微信入口等,具体到

SEO,两年前听到一个未经证实的数据,京东

SEO流量占总流量的比例大概

11%。作为对比,某知名在线旅游网站,

SEO流量占比达到了

30%。对于垃圾站群推的文学

/影视类网站,

SEO流量的占比应该不低于

90%吧。不同渠道的流量,转化率也会有所差异。对于电商来说,直接访问的流量,返利

/导购网站来的流量,一般都有相对明确的目的,也有一定的认知,所以决策曲线短,成单的概率大。下面画了一幅很假的饼图充数

:)

整站的整合营销,考虑的是整体的

ROI,有些时候为了配合大规模的促销活动,也会放低

ROI的标准,因为高转化的优质流量毕竟是有限的。当然,调节的细部手段还有提高网盟

CPS结算的返点,与搜索引擎等流量入口达成临时合作等等。可能有些未尝试过的流量,可以少量测试,总的策略是确保总量的前提下,提高总体

ROI,可以用

CPA或者

CPS的方式做内部衡量。

【流量跟踪】

最后简单说说

Track。我们一般统计流量,会用

GA,百度统计,

CNZZ,

51.la之类的统计工具,或者模仿这些工具,自己做个流量

track系统。对于外投的流量渠道,往往根据链接参数中的

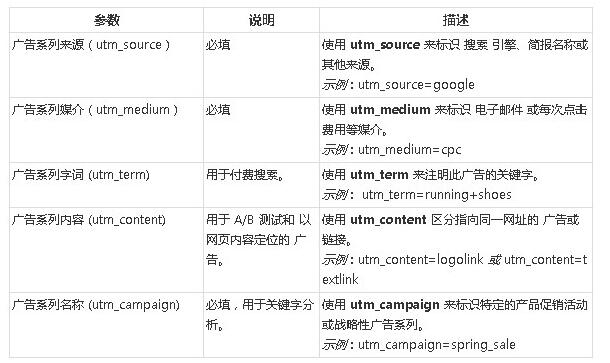

track码来区分来路,相对常见的是

GA中定义的一套,

当然,如果你不喜欢,你可以自己搞一套,比如

tracker_u这样奇怪的东东。

对于用户进入站内以后的行为,会根据用户

session存活周期,或者

cookie埋的

guid之类来监控。页面上埋

js代码,用户页面跳转或者点击页面内元素的动作,都会被

js发送到后台数据库,作为后续分析的依据。对于效果类流量的效果反馈,最直接的就是比如下载,订阅,或者加购物车,成单之类。

数据驱动的决策是科学的,拍脑袋依靠经验做的决策是耍流氓。所以说,流量之后,用户进入站点以后的行为的数据采集,不仅仅对于流量效果是个反馈,同时在站内进行精准推荐,或者在不违反用户隐私的前提下,将数据加工后,以类似于

DMP的方式放到

ADX中进行售卖,也是变现的一种方式。

全文完,谢谢观赏。

1号店刘苏,微信号 /QQ号 : 6109851,欢迎勾搭。

·上一篇文章:Seo的改变,就从今天就要开始!

·下一篇文章:无

转载请注明转载网址:

http://seo.jmkt.cn/news/zhishi/165231224456KK1C7F737H0DFC72534.htm

相关内容